Gaming-randapparatuurbedrijf Razer het is wedden dat mensen dat willen NAAR DE hologrammen. Zozeer zelfs dat het op CES 2026 een verbijsterend nieuw product introduceerde dat vroege critici een ‘vriend in een fles’ noemden. AVA-projecthet is een kleine glazen cilinder met een geanimeerde bureaugenoot van 5,5 inch die met je kan communiceren, je instructies kan geven of op verzoek in-game advies kan geven, allemaal beheerd door xAI’s Grok.

Project AVA maakt gebruik van een technologie die Razer “PC Vision Mode” noemt en die je scherm observeert, waardoor de 3D-geanimeerde bewoner realtime commentaar kan geven op je gameplay, je humeur kan volgen of gewoon rondhangen. Het probeert de illusie van aanwezigheid te verkopen: een metgezel die niet alleen een app is die je sluit, maar een fysiek object dat in je kamer leeft.

Het is geen Slecht een idee, in theorie. AI een gezicht geven is niet zomaar een marketing maar een biologische onvermijdelijkheid. Toch markeert Project AVA een vreemde nieuwe mijlpaal op ons pad naar AI-metgezellen.

De onvermijdelijkheid van holografische AI

Wanneer OpenAI geïntroduceerd ChatGPT 4o voicechats In de zomer van 2024 is de mensheid een nieuwe vorm van computerinteractie binnengegaan. Plotseling konden we communiceren met AI-stemmen die intelligent en natuurlijk genoeg waren voor mensen om een gesprek te voeren. Sindsdien hebben we andere stem-AI’s gezien, zoals Gemini Live, die pauzes, ademhaling en andere elementen introduceren die de griezelige vallei doorkruisen en velen in staat stellen hun ongeloof op te schorten en zelfs een band met deze assistenten te vormen.

Uit onderzoek is gebleken dat gebruikers voor een diepe emotionele uitlaatklep momenteel de voorkeur geven aan interfaces met alleen spraak, omdat ze zich veiliger en minder veroordelend voelen. Zonder een gezicht om te onderzoeken vermijden we de sociale angst om naar te worden gestaard. Echter, beweren sommige neurowetenschappers dat deze voorkeur slechts een tijdelijke oplossing kan zijn voor slechte technologie.

Onze hersenen zijn evolutionair ingesteld op face-to-face interactie. Het ‘spiegelneuronsysteem’ in onze hersenen, dat ons in staat stelt empathie te voelen als we naar anderen kijken, blijft grotendeels sluimerend tijdens alleen-stemchats. Een onderzoek uit 2024 op “Generation WhatsApp” bevestigde dat de neurale synchronisatie tussen twee hersenen aanzienlijk zwakker is tijdens uitwisselingen met alleen audio vergeleken met face-to-face uitwisselingen. Om ons echt ‘gehoord’ te voelen, moeten we dit doen Zien de luisteraar

Ook gedragswetenschappen vertelt hij ons dat tot 93% van de communicatie non-verbaal is. Zelfvertrouwen wordt gecodeerd in micro-expressies: een verwijde pupil, een snelle knipoog, een open houding. Een stemassistent zendt 0% van deze signalen uit, waardoor gebruikers in blind vertrouwen moeten opereren. Mensen vinden ze nog steeds erg boeiend omdat onze hersenen de gaten opvullen en zich gezichten voorstellen zoals wanneer we een boek lezen. Verder, volgens een hersenscanonderzoek uit 2025Bekende AI-stemmen activeren gebieden van emotionele regulatie, wat erop wijst dat neurale vertrouwdheid zich ontwikkelt bij herhaalde interactie.

De menselijke verbinding wordt dieper naarmate je jonger wordt (het demografische stadium van Razer). Terwijl oudere generaties daar grotendeels kunstmatige intelligentie voor gebruiken productiviteitGeneratie Z maakt vaak melding van het gebruik van geavanceerde stemmodaliteiten voor emotionele regulering en kameraadschap. Een rapport ze merkten op dat 72% van de tieners relaties had met AI-collega’s, waarbij een aanzienlijke subgroep hen als vertrouwelingen behandelde.

Ook dit heeft een donkere kant: Omdat de prefrontale cortex die verantwoordelijk is voor impulscontrole en realiteitstests nog niet volledig volwassen is bij adolescenten, kan empathie die door de huidige stem-AI’s wordt gesimuleerd gevaarlijk reëel lijken, wat leidt tot isolatie van menselijke leeftijdsgenoten of emotionele manipulatie door het model.

Maar hoewel stem-AI’s een krachtige gebruikerservaring bieden, zullen ze nooit de directe gezichtsinteractie kunnen evenaren. Studies voorstellen dat zodra we de ‘griezelige vallei’ hebben opgelost – dat vreemde gevoel van afkeer dat we krijgen als iemand bijna, maar niet helemaal menselijk lijkt – onze hersenen zich op natuurlijke wijze naar die persoon zullen toetrekken. Op dat moment zouden holografische persona’s een algemene gebruikerservaring kunnen worden in bedrijven en intieme relaties.

Het Ava-project is dat niet

Al zijn we nog lang niet zover. We zullen hyperrealistische AI-gezichten nodig hebben die algoritmisch zijn geoptimaliseerd om er precies zo uit te zien als mensen, met elke spier, teek en imperfectie.

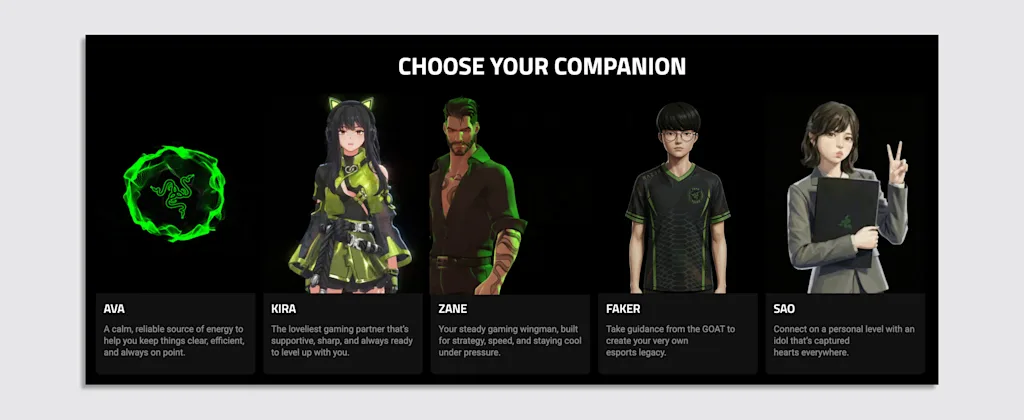

Om de griezelige vallei in het AVA-ontwerp te vermijden, koos Razer voor gestileerde avatars. Er is “Kira”, een personage in anime-stijl, “Zane”, een coach voor strategiespellen en zelfs een gelicentieerde avatar van eSports-legende “Faker”. Het doel is om in te spelen op de parasociale dynamiek die al gebruikelijk is in de gamingcultuur, waar digitale karakters zich vaak meer als vrienden dan als software voelen.

Vroege praktische ervaringen suggereren dat de illusie kwetsbaar is. Recensies beschrijven de interactie als “wankel”, waarbij het hologram regelmatig wordt geactiveerd op irrelevante raaklijnen. Critici noemden het al snel een “vriend in een pot”, zich afvragend of het een echte sociale behoefte bevredigt of eenvoudigweg de eenzaamheid uitbuit met een visuele gimmick. Bovendien, en dit is belangrijk, is het geen echt hologram. Dit zijn slechts 3D-geanimeerde karakters die op een vlakke transparante film worden geprojecteerd. Ga opzij en je vriend wordt gereduceerd tot 2D-onzichtbaarheid.

Ethische zorgen worden groter als je onder de motorkap kijkt. Hoewel Razer zegt dat de hardware model-agnostisch is, wordt de huidige iteratie mogelijk gemaakt door xAI’s Grok, het ethisch uitgedaagde AI-model van Elon Musk. Dit verbindt het apparaat onmiddellijk met de donkere kant van de AI-ontwikkeling.

Deze week nog was Grok verwikkeld in een mondiaal schandaal met betrekking tot de nieuwe “bewerk”-functie, die gebruikers hebben uitgebuit om seksuele beelden zonder wederzijds goedvinden genereren met een snelheid van één beeld per minuut. Terwijl de avatars van Project AVA gestileerd en geblokkeerd zijn door Razer, wordt de associatie met een engine weergegeven wordt momenteel onderzocht door de EU en Britse toezichthouders die ‘massaal digitaal uitkleden’ vergemakkelijken, werpen een lange schaduw over het product. Er is geen garantie dat gebruikers geen manieren zullen vinden om AVA te jailbreaken om zich op een even controversiële manier te gedragen, waardoor een gamemanager in iets veel onaangenamer verandert.

Het is echter een eerste stap. De markt gokt al op deze verandering. De holografische AI-assistent-industrie zal naar verwachting groeien van ongeveer $600 miljoen in 2024 naar… bijna 4 miljard dollar in 2031. We zien al succesvolle toepassingen in de gezondheidszorg, waar gebruikers AI-avatars verkleed als artsen als competenter beoordelen dan agenten die alleen met hun stem spreken, en ook in klantenservicekiosken waar een digitaal gezicht helpt de aandacht van de gebruiker vast te houden.

AVA zinspeelt op deze toekomst, maar heeft de fundamentele problemen nog niet opgelost. Om natuurlijk te worden, moet een holografische AI meer zijn dan alleen een gimmick in een glas. Het moet een zijn hoeveelheid slimmer dan Grok en zal over de subtiele sociale signalen moeten beschikken die de veiligheid van ons zenuwstelsel signaleren. Tot die tijd zal AVA slechts een grof speeltje zijn

Ik wijs het echter niet af. Gezien onze biologische noodzaak is het logisch om te denken dat mensen in toekomstige UX-ervaringen zullen neigen naar holografische manifestaties van AI. Maar hoewel holografische AI onvermijdelijk is, lijkt Ava dat niet te zijn Het. Met een beetje geluk zal het herinnerd worden als een prototype van wat komen gaat. Iets echt geavanceerd dat hopelijk niet zal worden aangedreven door de afstammelingen van een technofascistische AI.