- Meta en Nvidia lanceren meerjarig partnerschap voor grootschalige AI-infrastructuur

- Miljoenen Nvidia’s Arm-gebaseerde GPU’s en CPU’s kunnen extreme werklasten aan

- De uniforme architectuur strekt zich uit over datacenters en Nvidia-cloudpartnerimplementaties

Meta heeft een meerjarige samenwerking aangekondigd met Nvidia Het doel was om een grootschalige AI-infrastructuur te bouwen die een aantal van de grootste werklasten in de technologie-industrie aankan.

Deze samenwerking zal miljoenen distribueren GPU EN ArmCPU-gebaseerde technologieën, breiden de netwerkcapaciteit uit en integreren geavanceerde privacybehoudende computertechnieken in de platforms van het bedrijf.

Het initiatief heeft tot doel de uitgebreide productieworkloads van Meta te combineren met het hardware- en software-ecosysteem van Nvidia om de prestaties en efficiëntie te optimaliseren.

Uniforme architectuur voor alle datacenters

De twee bedrijven creëren een uniforme infrastructuurarchitectuur die zich on-premise uitstrekt datacentra en implementaties van Nvidia-cloudpartners.

Deze aanpak vereenvoudigt de bedrijfsvoering door schaalbare, krachtige computerbronnen te bieden voor AI-training en -inferentie.

“Niemand zet AI in op de schaal van Meta, waarbij grensverleggend onderzoek wordt geïntegreerd met infrastructuur op industriële schaal om ‘s werelds grootste personalisatie- en aanbevelingssystemen voor miljarden gebruikers aan te drijven,” zei hij Jensen Huang, oprichter en CEO van Nvidia.

“Door diepgaand co-ontwerp van CPU, GPU, netwerken en software brengen we het volledige Nvidia-platform naar Meta-onderzoekers en -ingenieurs terwijl zij de basis leggen voor de volgende grens van kunstmatige intelligentie.”

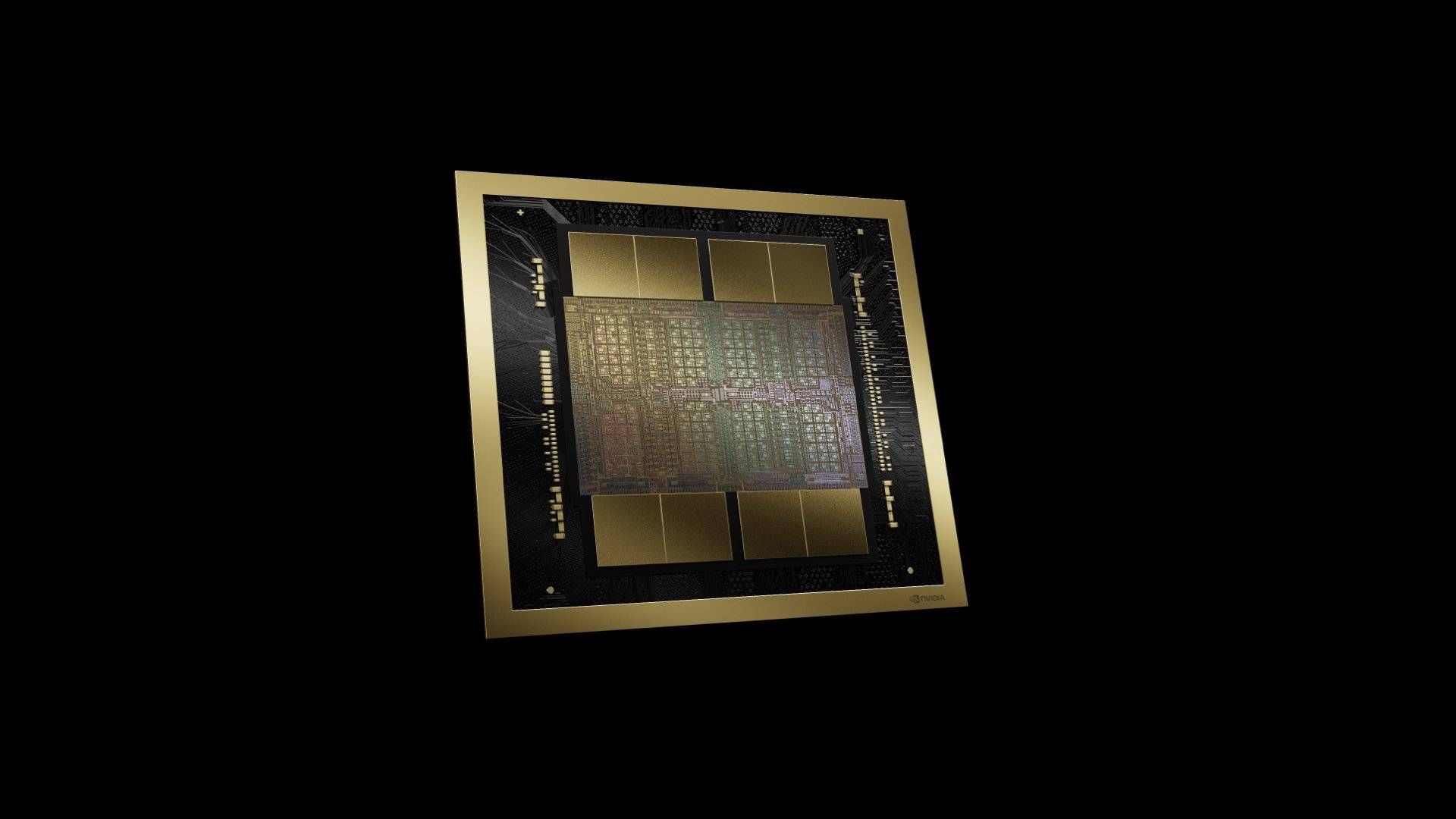

Nvidia’s Op GB300 gebaseerde systemen zal de ruggengraat vormen van deze implementaties. Ze zullen een platform aanbieden dat rekenkracht, geheugen en opslag integreert om te voldoen aan de behoeften van de volgende generatie AI-modellen.

Meta breidt ook Nvidia Spectrum-X Ethernet uit over zijn netwerk en streeft ernaar voorspelbare prestaties met lage latentie te leveren en tegelijkertijd de operationele en energie-efficiëntie voor grootschalige werklasten te verbeteren.

Meta is begonnen met het adopteren van Nvidia Confidential Computing om AI-aangedreven functies binnenin te ondersteunen WhatsAppwaardoor machine learning-modellen gebruikersgegevens kunnen verwerken met behoud van privacy en integriteit.

De samenwerking is van plan deze aanpak uit te breiden naar andere Meta-diensten, waarbij privacy-geoptimaliseerde AI-technieken in meer toepassingen worden geïntegreerd.

Technische teams bij Meta en Nvidia werken nauw samen om AI-modellen samen te ontwerpen en software voor de hele infrastructuurstack te optimaliseren.

Door hardware, software en workloads op één lijn te brengen, willen bedrijven de prestaties per watt verbeteren en de training voor geavanceerde modellen versnellen.

Nvidia Grace grootschalige implementatie CPU is een belangrijk onderdeel van deze inspanning, waarbij de samenwerking de eerste grote Grace-only-implementatie op deze schaal vertegenwoordigt.

We implementeren ook software-optimalisaties in CPU-ecosysteembibliotheken om de doorvoer en energie-efficiëntie voor volgende generaties AI-workloads te verbeteren.

“We zijn verheugd om onze samenwerking met Nvidia uit te breiden om geavanceerde clusters te creëren met behulp van hun Vera Rubin-platform om persoonlijke superintelligentie te leveren aan iedereen ter wereld,” zei hij Mark Zuckerberg, oprichter en CEO van Meta.

Volg TechRadar op Google Nieuws EN voeg ons toe als uw favoriete bron om nieuws, recensies en meningen van onze experts in uw feeds te krijgen. Klik dan zeker op de knop Volgen!

En jij kunt dat natuurlijk ook Volg TechRadar op TikTok voor nieuws, recensies, unboxing in videoformaat en ontvang regelmatig updates van ons WhatsApp ook.